Apparaitre dans les premiers résultats sur internet ? Spécialisée dans l’audit SEO, notre agence Tactee vous propose des solutions adaptées dans vos projets de stratégie web.

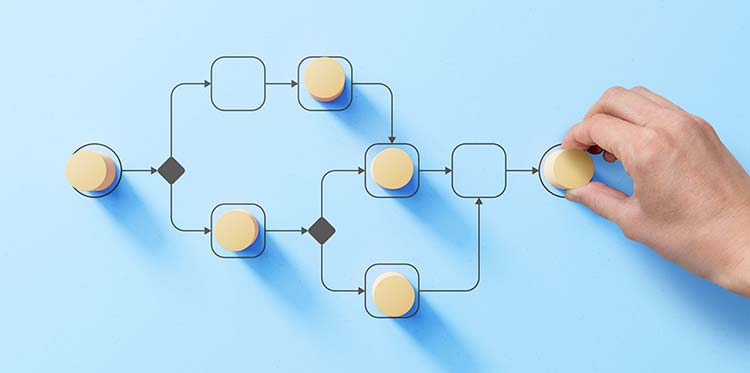

Auditer l’aspect technique de votre site

Un audit technique a pour but de comprendre le niveau de référencement naturel de votre site. Il peut expliquer les raisons d’un faible trafic sur un site/une URL, la perte de positionnement de mots-clés ou des problèmes d’indexation par exemple. En analysant ces données par un audit technique, cela permet d’apporter les correctifs nécessaires et d’améliorer le référencement Google du site.